最小二乘法(Least Squares method),又称最小平方法,它通过最小化误差的平方和寻找数据的最佳拟合函数。

最小二乘问题分为两种:线性最小二乘法,和非线性最小二乘法,取决于在所有未知数中的残差是否为线性。

- 线性最小二乘问题发生在统计回归分析中;它有一个解析解。

- 而非线性的问题通常经由迭代细致化来解决。

线性最小二乘法

二元方程模型(帮助理解)

二元一次方程的一般形式是:

y=ax+b

其中,a,b 是实数或复数,x,y 是未知数。

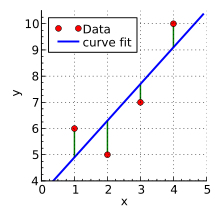

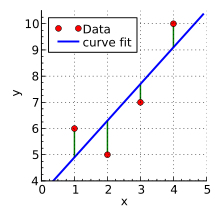

现在问题假设有 m 个样本数据点 (x1,y1),(x2,y2),...,(xm,ym),其中 xi 是自变量,yi 是因变量。我们希望用一条直线来拟合这些数据点。

基本思想是,找到一组参数( β0 斜率和 β1 截距),使得这组参数下的拟合直线与所有数据点之间的平方误差之和最小。也就是说,最小二乘法通过最小化残差平方和来估计参数。用数学公式描述就是:

Q=mini∑n(yie−yi)2

其中, yie 表示根据 y=β0+β1x 估算值, yi 是观察得到的真实值。

所以可知优化的损失函数为:

Q=mini∑n(yi−β0−β1x)2

现在需要确定 β0 β1,使损失函数最小,即对公式进行求导,函数的极小值点为偏导为0的点。

∂β0∂Q=2i∑n(yi−β0−β1xi)(−1)=0∂β1∂Q=2i∑n(yi−β0−β1xi)(−xi)=0

将这两个方程稍微整理一下,使用克莱姆法则,很容易求解得出:

β0=n∑xi2−(∑xi)2∑xi2∑yi−∑xi∑xiyiβ1=n∑xi2−(∑xi)2n∑xiyi−∑xi∑yi

这就是最小二乘法的解法,就是求得平方损失函数的极值点。需要注意的一点是 β0 是常数项对应的系数,此处相当于添加了一个特征值 x0 且 x0 恒为 1 ,也就是目标函数中的 β0 可以看成 β0x0, 这样的话就不用单独考虑常数项了(在后面的多元线性模型就用到了该性质)。

多元模型

假设现在有 m 个样本,每个样本有 n−1 维特征,其中 x0=1 将所有样本点代入多元模型中得:

h1=θ0x0+θ1x1,1+θ2x1,2+…+θn−1x1,n−1 h2=θ0x0+θ1x2,1+θ2x2,2+…+θn−1x2,n−1⋮hm=θ0x0+θ1xm,1+θ2xm,2+…+θn−1xm,n−1

对于多元模型,我们通常将其转化为矩阵更为便捷,于是上述方程可以用矩阵表示为:

h=Xθ

其中,h 为 m×1 的向量代表真实值,θ 为 n×1 的向量是参数,X 为 m\timesn 维的矩阵是输入,m 代表样本的个数 n 代表样本的特征数,目标损失函数用矩阵表示为:

J(θ)=∥h−Y∥2=∥Xθ−Y∥2=(Xθ−Y)T(Xθ−Y)

其中 Y 是样本的输出向量, 维度为 m×1 。

先对 J(θ) 化简:

=(Xθ−Y)T(Xθ−Y)=(θTXT−YT)(Xθ−Y)=θTXTXθ−θTXTY−YTXθ+YTY=θTXTXθ−2θTXTY+YTY

然后利用该式对向量 θ 求导:

∂θ∂(θTATAθ−2θTATY+YTY)=∂θ∂(θTATAθ−2θTATY)=∂θ∂(θTATAθ)−2ATY(1)

由矩阵的求导法则:

dxd(xTAx)=dxd(xT)⋅Ax+dxd(xTAT)⋅x=(A+AT)x

对等式(1)继续化简为:

∂θ∂(θTXTXθ)−2XTY=(XTX+XTX)θ−2XTY=2(XTXθ−XTY)

令上式结果等于0可得:

∂θ∂J(θ)=2XTXθ−2XTY=0

解得 θ=(XTX)−1XTY ,只要带入数据,就可以直接算出 θ 。

最小二乘法的问题

观察上面的结论可知如果 (XTX)−1 为奇异矩阵时(不可逆),此时解析解无法进行计算。导致该问题的可能的原因是 X 中的列向量线性相关,数据中存在特征冗余,某些特征可以根据其它特征的线性组合来得到。

此外,当 (XTX)−1 为病态矩阵(ill-conditioned matrix) 时,最小二乘法也会失效,在求解方程组时对数据的微小扰动比较敏感,结果缺乏稳定性。

为了改善这些问题,又提出了以下几种改进的线性最小二乘法:

- 岭回归(Ridge Regression):岭回归是一种正则化方法,通过在目标函数中增加一个正则项来限制参数的大小。这种方法可以有效地解决过拟合问题。

- Lasso回归:Lasso回归也是一种正则化方法,它使用L1正则化来对参数进行限制,将一些参数收缩到零,从而实现特征选择的目的。

- 弹性网络(Elastic Net):弹性网络是一种结合了L1正则化和L2正则化的方法,可以综合Lasso回归和岭回归的优点,具有较好的特征选择能力和模型稳定性。

- 最小角回归(Least Angle Regression,LARS):最小角回归是一种迭代方法,通过一步步地选择重要的特征来构建模型,可以有效地处理高维数据集。

- 局部加权线性回归(Locally Weighted Linear Regression,LWLR):局部加权线性回归是一种非参数回归方法,它不需要预先设定模型的形式,而是在每个预测点附近进行局部线性拟合,可以适应各种不规则数据集。

这些改进的线性最小二乘法方法都在一定程度上提高了模型的性能和鲁棒性,可以根据不同的数据集和实际需求选择合适的方法。

参考:

详解岭回归与L2正则化

机器学习十大经典算法之最小二乘法

一文让你彻底搞懂最小二乘法(超详细推导)

非线性最小二乘法

评论区